Google rivoluziona AI e sicurezza: arrivano CodeMender e Gemini Robotics-ER 1.5 🤖🔒

Negli ultimi giorni sono uscite due novità che, messe insieme, rimescolano il mio modo di pensare a sviluppo, sicurezza e robotica. Da una parte c’è CodeMender, un agente AI pensato per individuare e correggere automaticamente vulnerabilità nel codice; dall’altra Gemini Robotics-ER 1.5, un modello di embodied reasoning che spinge l’IA dal “pensare” al “fare” nel mondo fisico.

In questo articolo li affronto separatamente e poi provo a tirare le somme: perché sono importanti, cosa comportano per chi sviluppa e come conviene prepararsi.

🛠️ CodeMender — l’AI che sistema il codice (o ci prova)

Cosa è: CodeMender è un agente AI progettato per analizzare repository, individuare falle di sicurezza e proporre (o applicare, con controllo umano) patch automatiche per correggere vulnerabilità. L’idea è trasformare l’AI in un “manutentore” del codice, capace di intervenire rapidamente su difetti che altrimenti resterebbero nascosti a lungo.

Perché è rilevante: la supply chain del software e gli strumenti build/test sono spesso punti deboli: non è solo il codice prodotto che può avere bug, ma anche gli strumenti che lo maneggiano. Un agente come CodeMender può ridurre il tempo fra scoperta della vulnerabilità e patching effettivo, diminuendo la finestra di esposizione e alleggerendo il carico dei manutentori.

Limiti & attenzione: automatizzare patch significa anche dover validare le modifiche (regressioni, comportamenti non voluti, compatibilità). Il modello prevede — e deve prevedere — meccanismi di review umana e test continui, oltre a una governance chiara su cosa può essere applicato automaticamente e cosa richiede approvazione.

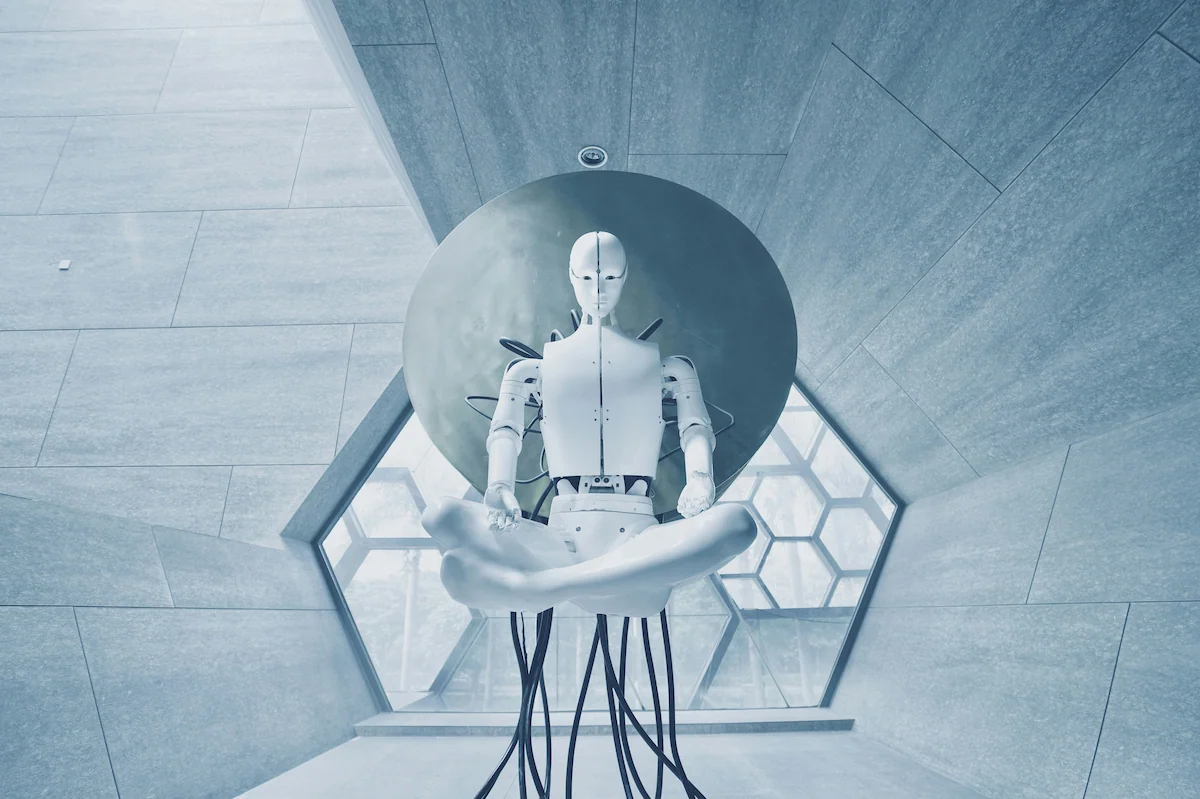

🤖 Gemini Robotics-ER 1.5 — l’IA che orchestra l’azione fisica

Cosa è: Gemini Robotics-ER 1.5 è una versione del modello Gemini progettata per l’ “embodied reasoning”: non solo visione e linguaggio, ma capacità di pianificare, ragionare spazialmente e orchestrare azioni robotiche in ambienti reali o simulati. Si tratta di un passo verso robot che non eseguono solo comandi predefiniti, ma comprendono il compito e lo traducono in sequenze di azioni.

Cosa può fare: il modello eccelle nello spatial reasoning (punti 2D precisi, stime di dimensione/peso/affordance), nella pianificazione di azioni complesse e nella capacità di trasferire apprendimento da simulazioni al mondo reale — tutto ciò rende possibili applicazioni come manipolazione, pulizia, assistenza domestica e operazioni in ambienti strutturati.

Implicazioni pratiche: per chi sviluppa robot o sistemi di automazione significa avere un “cervello” capace di decidere strategie e adattarsi a situazioni nuove. Ma attenzione: maggiore autonomia richiede controlli di sicurezza, monitoraggio e meccanismi di fallback per evitare comportamenti pericolosi o non desiderati.

🔗 Mettere insieme le due novità: sicurezza + embodied AI

Queste due innovazioni vanno lette insieme: se d’un lato rendere il codice più sicuro con agenti automatici riduce i rischi software, dall’altro la diffusione di modelli che comandano robot amplifica le conseguenze di un errore software. Il mix crea una doppia esigenza:

- Code assurance rafforzata: qualsiasi sistema che controlli un robot deve essere sottoposto a controlli di sicurezza automatici e manuali, test di regressione, fuzzing e audit. Agent come CodeMender possono diventare parte del processo di hardening, ma non sostituiscono il testing fisico.

- Sicurezza fisica e fallback: i robot con reasoning autonomo devono avere modalità “safe” (arresto immediato, ritorno in stato sicuro, supervisione umana). L’affidabilità del software diventa ora più che mai anche affidabilità fisica.

✅ Cosa faccio (e ti consiglio) da subito

- Integrare controlli automatici: usare tool automatici per scanning e patching come primo filtro, ma con pipeline CI che includano test approfonditi.

- Mantenere una review umana obbligatoria per le patch generate automaticamente (specialmente su codice che guida hardware).

- Testare in simulazione e in safety-mode prima di trasferire modelli robotici sul campo (la simulazione è preziosa ma non basta).

- Progettare fallback e strumenti di teleoperazione per intervenire rapidamente se qualcosa va storto.

✨ In sintesi — non è fantascienza, è responsabilità

CodeMender e Gemini Robotics-ER 1.5 sono due segnali potenti: l’AI può aiutare a riparare il codice e può far agire il mondo fisico in modo intelligente. Ma questa potenza porta con sé una responsabilità enorme: dobbiamo costruire flussi di lavoro che combinino automazione e controllo umano, test rigorosi e protocolli di sicurezza che tengano conto sia delle vulnerabilità logiche che dei rischi fisici.

Se lavori con IA, robotica o integrazione di sistemi, è il momento di prendere sul serio entrambi i fronti: migliorare la difesa del codice e progettare robot che sbagliano in modo sicuro. Il futuro è affascinante — e lo sarà ancora di più se lo rendiamo anche sicuro. 🚀🔐🤖